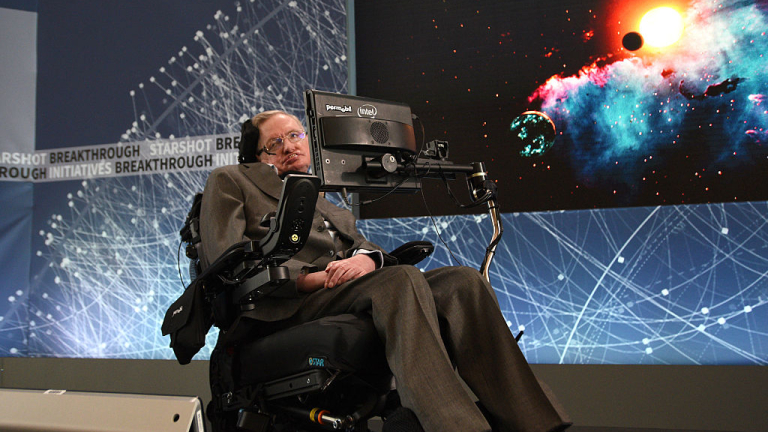

Появата и развитието на изкуствения интелект може да е най-лошото нещо в историята на цивилизацията, ако обществото не намери начин да го контролира. За това предупреждава британският физик Стивън Хокинг, цитиран от CNBC.

Той коментира тази тема по време на реч в рамките на специализираната конференция в Лисабон Web Summit.

По неговите думи на теория компютрите могат да подражават на човешкия интелект и да го надминат. Все пак Хокинг смята, че изкуственият интелект би могъл да помогне за преодоляване на проблемите, причинени на природата от хората или за изкореняване на бедността и заболяванията.

Въпреки това ученият се опасява, че бъдещето около технологиите е прекалено несигурно.

"Успехът в създаването на ефективен изкуствен интелект може да е най-голямото събитие в човешката история. Но и най-лошото. Ние просто все още не знаем. Така че не можем да разберем дали ще технологиите ще ни помогнат или ще бъдем унищожени от тях", коментира той.

"Ако не се подготвим за тези промени и ги игнорираме, потенциалните рискове могат да се превърнат в най-лошото за цивилизацията. Промените носят опасности, подобно на мощните автономни оръжия. Те могат да предизвикат и сериозни смущения в икономиката", твърди още Стивън Хокинг.

Като добър пример към опитите за регулиране на развитието на технологиите той дава волята за законодателни промени в Европа. Лидерите на държавите членки от Европейския съюз (ЕС) заявиха, че са нужни нови правила, свързани с изкуствения интелект и роботиката.

"Аз съм оптимист и вярвам, че можем да създадем изкуствен интелект за един по-добър свят. Смятам, че той може да работи в хармония с нас. Ние просто трябва да внимаваме за опасностите, да ги отчитаме и да заложим на най-добрите практики, които да ни подготвят за последствията предварително", завършва Хокинг.

USD

USD CHF

CHF EUR

EUR GBP

GBP